Supercomputer - Supercomputer

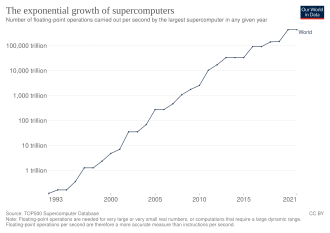

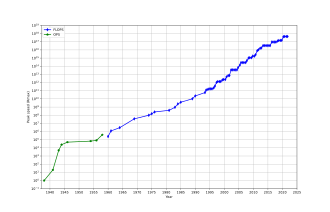

Un supercomputer este un computer cu un nivel ridicat de performanță în comparație cu un computer de uz general . Performanța unui supercomputer este de obicei măsurată în operații în virgulă mobilă pe secundă ( FLOPS ) în loc de milioane de instrucțiuni pe secundă (MIPS). Din 2017, există supercomputere care pot efectua peste 10 17 FLOPS (o sută de miliarde FLOPS, 100 petaFLOPS sau 100 PFLOPS).

Pentru comparație, un computer desktop are performanțe cuprinse între sute de gigaFLOPS și zeci de teraFLOPS.

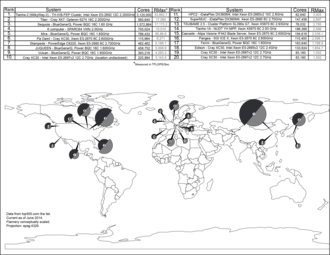

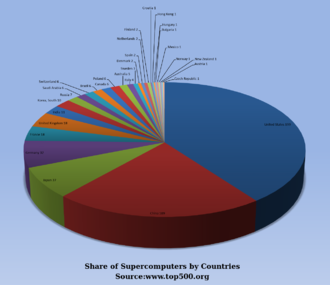

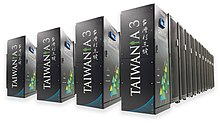

Din noiembrie 2017, cele mai rapide 500 de supercalculatoare din lume rulează sisteme de operare bazate pe Linux . Se efectuează cercetări suplimentare în Statele Unite , Uniunea Europeană , Taiwan , Japonia și China pentru a construi supercalculatoare exascale mai rapide, mai puternice și superioare din punct de vedere tehnologic .

Supercomputerele joacă un rol important în domeniul științei computaționale și sunt utilizate pentru o gamă largă de sarcini intensive din punct de vedere calculațional în diverse domenii, inclusiv mecanica cuantică , prognoza meteo , cercetarea climei , explorarea petrolului și gazelor , modelarea moleculară (calculul structurilor și proprietăților de compuși chimici, macromolecule biologice , polimeri și cristale) și simulări fizice (cum ar fi simulările primelor momente ale universului, aerodinamica avionului și a navei spațiale , detonarea armelor nucleare și fuziunea nucleară ). Acestea au fost esențiale în domeniul criptanalizei .

Supercomputerele au fost introduse în anii 1960 și, timp de câteva decenii, cele mai rapide au fost realizate de Seymour Cray la Control Data Corporation (CDC), Cray Research și companiile ulterioare care îi purtau numele sau monograma. Primele astfel de mașini au fost modele convenționale foarte bine reglate, care au funcționat mai repede decât contemporanii lor de uz general. De-a lungul deceniului, s-au adăugat cantități tot mai mari de paralelism , unul până la patru procesoare fiind tipice. În anii 1970, procesoarele vectoriale care operează pe matrice mari de date au ajuns să domine. Un exemplu notabil este Cray-1 de mare succes din 1976. Calculatoarele vectoriale au rămas designul dominant în anii '90. De atunci și până astăzi, supercalculatoarele masiv paralele cu zeci de mii de procesoare standard au devenit norma.

SUA a fost mult timp liderul în domeniul supercomputerelor, mai întâi prin dominarea aproape neîntreruptă a domeniului Cray, iar mai târziu printr-o varietate de companii de tehnologie. Japonia a făcut progrese majore în domeniu în anii 1980 și 90, China devenind din ce în ce mai activă în domeniu. Începând din iunie 2020, cel mai rapid supercomputer din lista de supercalculatoare TOP500 este Fugaku , în Japonia, cu un scor de referință LINPACK de 415 PFLOPS, urmat de Summit , cu aproximativ 266,7 PFLOPS. SUA are patru dintre primii 10; China și Italia au câte două, Elveția are una. În iunie 2018, toate supercomputerele combinate de pe lista TOP500 au rupt marca 1 exaFLOPS .

Istorie

În 1960, UNIVAC a construit calculatorul Livermore Atomic Research (LARC), considerat astăzi printre primele supercomputere, pentru Centrul de cercetare și dezvoltare al US Navy. Folosea în continuare memorie de tambur de mare viteză , mai degrabă decât noua tehnologie a unității de disc . De asemenea, printre primele supercomputere a fost IBM 7030 Stretch . IBM 7030 a fost construit de IBM pentru Laboratorul Național Los Alamos , care în 1955 ceruse un computer de 100 de ori mai rapid decât orice computer existent. IBM 7030 a folosit tranzistoare , memorie cu miez magnetic, instrucțiuni conductate , date preluate prin intermediul unui controler de memorie și a inclus unități de disc cu acces aleator pionier. IBM 7030 a fost finalizat în 1961 și, în ciuda faptului că nu a îndeplinit provocarea unei creșteri de sute de ori a performanței, a fost achiziționat de Laboratorul Național Los Alamos. Clienții din Anglia și Franța au cumpărat și computerul și a devenit baza IBM 7950 Harvest , un supercomputer construit pentru criptanaliză .

Al treilea proiect de supercomputer pionier la începutul anilor 1960 a fost Atlasul de la Universitatea din Manchester , construit de o echipă condusă de Tom Kilburn . El a proiectat Atlas pentru a avea spațiu de memorie de până la un milion de cuvinte de 48 de biți, dar pentru că stocarea magnetică cu o astfel de capacitate era inaccesibilă, memoria centrală reală a Atlasului era de numai 16.000 de cuvinte, cu un tambur care oferă memorie pentru încă 96.000 cuvinte. Sistemul de operare Atlas a schimbat datele sub formă de pagini între nucleul magnetic și tambur. Sistemul de operare Atlas a introdus, de asemenea , partajarea timpului la supercomputere, astfel încât mai multe programe să poată fi executate pe supercomputer în orice moment. Atlas a fost o societate mixtă între Ferranti și Universitatea din Manchester și a fost proiectat să funcționeze la viteze de procesare care se apropie de o microsecundă pe instrucțiune, aproximativ un milion de instrucțiuni pe secundă.

CDC 6600 , proiectat de Seymour Cray , a fost terminată în 1964 și a marcat trecerea de la germaniu la siliciu tranzistori. Tranzistoarele din siliciu ar putea funcționa mai repede și problema supraîncălzirii a fost rezolvată prin introducerea refrigerării în designul supercomputerului. Astfel, CDC6600 a devenit cel mai rapid computer din lume. Având în vedere că modelul 6600 a depășit toate celelalte computere contemporane de aproximativ 10 ori, a fost supranumit supercomputer și a definit piața supercomputerului, când o sută de computere au fost vândute la 8 milioane de dolari fiecare.

Cray a părăsit CDC în 1972 pentru a-și forma propria companie, Cray Research . La patru ani după ce a părăsit CDC, Cray a livrat Cray-1 de 80 MHz în 1976, care a devenit unul dintre cele mai de succes supercalculatoare din istorie. Cray-2 a fost lansat în 1985. Acesta a avut opt unități centrale de procesare (CPU), lichid de răcire și agentul de răcire electronică lichid Fluorinert a fost pompat prin arhitectura supercomputer . A ajuns la 1,9 gigaFLOPS , devenind primul supercomputer care a rupt bariera gigaflop.

Proiecte masiv paralele

Singurul computer care a provocat serios performanța Cray-1 în anii 1970 a fost ILLIAC IV . Această mașină a fost primul exemplu realizat al unui adevărat computer masiv paralel , în care mulți procesoare au lucrat împreună pentru a rezolva diferite părți ale unei singure probleme mai mari. Spre deosebire de sistemele vectoriale, care au fost concepute pentru a rula un singur flux de date cât mai repede posibil, în acest concept, computerul alimentează în schimb părți separate ale datelor către procesoare complet diferite și apoi recombină rezultatele. Designul ILLIAC a fost finalizat în 1966 cu 256 de procesoare și oferă viteză de până la 1 GFLOPS, comparativ cu vârful Cray-1 din anii 1970 de 250 MFLOPS. Cu toate acestea, problemele de dezvoltare au dus la construirea a doar 64 de procesoare, iar sistemul nu ar putea opera niciodată mai repede decât aproximativ 200 MFLOPS, fiind în același timp mult mai mare și mai complex decât Cray. O altă problemă a fost că scrierea software-ului pentru sistem a fost dificilă, iar obținerea performanțelor maxime de la acesta a fost o chestiune de efort serios.

Dar succesul parțial al ILLIAC IV a fost văzut pe scară largă ca indicând drumul către viitorul supercomputerii. Cray s-a certat împotriva acestui lucru, spunând că „Dacă ari un câmp, pe care ai prefera să-l folosești? Doi boi puternici sau 1024 de găini?” Dar la începutul anilor 1980, mai multe echipe lucrau la proiecte paralele cu mii de procesoare, în special Connection Machine (CM) care s-a dezvoltat din cercetări la MIT . CM-1 a folosit până la 65.536 microprocesoare personalizate simplificate conectate împreună într-o rețea pentru a partaja date. Au urmat mai multe versiuni actualizate; supercomputerul CM-5 este un computer de procesare masiv paralel capabil de multe miliarde de operații aritmetice pe secundă.

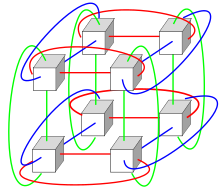

În 1982, Osaka University „s LEGĂTURI-1 Computer Graphics System a folosit o paralelă masivă arhitectura de procesare, cu 514 microprocesoare , inclusiv 257 Zilog Z8001 procesoare de control și 257 iAPX 86/20 procesoare în virgulă mobilă . A fost utilizat în principal pentru redarea graficelor computerizate 3D realiste . VPP500 de la Fujitsu din 1992 este neobișnuit, deoarece, pentru a obține viteze mai mari, procesoarele sale au folosit GaAs , un material rezervat în mod normal pentru aplicațiile cu microunde datorită toxicității sale. Supercomputerul numeric al tunelului eolian al Fujitsu a folosit 166 de procesoare vectoriale pentru a câștiga primul loc în 1994 cu o viteză maximă de 1,7 gigaFLOPS (GFLOPS) per procesor. Hitachi SR2201 a obținut o performanță de vârf de 600 Gflops in 1996 , prin utilizarea de 2048 procesoare conectate printr - un rapid tridimensional bara transversală rețea. Intel Paragon ar putea avea de la 1000 la 4000 Intel i860 procesoare în diferite configurații și a fost clasat pe locul cel mai rapid din lume în 1993. Paragon a fost o MIMD mașină care conectat procesoare printr - o sită cu ochiuri de două-dimensional de mare viteză, permițând procese să execute pe noduri separate , comunicând prin interfața de transmitere a mesajelor .

Dezvoltarea de software a rămas o problemă, dar seria CM a declanșat cercetări considerabile în această problemă. Modele similare utilizând hardware - ul clientului au fost făcute de multe companii, inclusiv Evans & Sutherland ES-1 , MasPar , Ncube , Intel IPSC și MPP Goodyear . Dar la mijlocul anilor 1990, performanțele CPU de uz general s-au îmbunătățit atât de mult, încât un supercomputer putea fi construit folosindu-le ca unități individuale de procesare, în loc să folosească cipuri personalizate. Până la începutul secolului al XXI-lea, design-urile cu zeci de mii de procesoare de marfă erau norma, iar mașinile ulterioare adăugau unități grafice la mix.

Sistemele cu un număr masiv de procesoare iau în general una din cele două căi. În abordarea de calcul al rețelei , puterea de procesare a multor computere, organizată ca domenii administrative distribuite și diverse, este utilizată oportunist ori de câte ori este disponibil un computer. Într-o altă abordare, multe procesoare sunt utilizate în apropierea unul de altul, de exemplu într-un cluster de calculatoare . Într-un astfel de sistem centralizat paralel masiv , viteza și flexibilitatea sistemului interconectarea devine foarte importantă, iar supercomputerele moderne au folosit diverse abordări, de lasistemeInfinibandîmbunătățitelainterconectări torustridimensionale. Utilizareaprocesoarelor multi-corecombinate cu centralizarea este o direcție emergentă, de exemplu ca în sistemulCyclops64.

Pe măsură ce prețul, performanța și eficiența energetică a unităților de procesare grafică de uz general (GPGPU) s-au îmbunătățit, un număr de supercomputere petaFLOPS precum Tianhe-I și Nebulae au început să se bazeze pe ele. Cu toate acestea, alte sisteme, cum ar fi computerul K, continuă să utilizeze procesoare convenționale, cum ar fi proiectele bazate pe SPARC și aplicabilitatea generală a GPGPU-urilor în aplicații de calcul de înaltă performanță de uz general a făcut obiectul dezbaterii, în timp ce un GPGPU poate fi reglat pentru a înscrie bine pe anumite repere, aplicabilitatea sa generală la algoritmii de zi cu zi poate fi limitată, cu excepția cazului în care se depune eforturi semnificative pentru a regla aplicația. Cu toate acestea, GPU-urile câștigă teren, iar în 2012 supercomputerul Jaguar a fost transformat în Titan prin adaptarea CPU-urilor cu GPU-uri.

Computerele performante au un ciclu de viață preconizat de aproximativ trei ani înainte de a necesita o actualizare. Gyoukou Supercomputerul este unic prin faptul că folosește atât un design masiv paralel și imersiune lichid de răcire .

Supercalculatoare cu destinație specială

Au fost proiectate o serie de sisteme special destinate unei singure probleme. Acest lucru permite utilizarea cipurilor FPGA special programate sau chiar a ASIC-urilor personalizate , permițând rapoarte mai bune preț / performanță prin sacrificarea generalității. Exemple de supercomputere cu destinație specială includ Belle , Deep Blue și Hydra pentru jocul de șah , Gravity Pipe pentru astrofizică, MDGRAPE-3 pentru predicția structurii proteinelor și dinamica moleculară și Deep Crack pentru ruperea cifrului DES .

Utilizarea energiei și gestionarea căldurii

De-a lungul deceniilor, gestionarea densității căldurii a rămas o problemă cheie pentru majoritatea supercomputerelor centralizate. Cantitatea mare de căldură generată de un sistem poate avea și alte efecte, de exemplu reducerea duratei de viață a altor componente ale sistemului. Au existat diverse abordări ale gestionării căldurii, de la pomparea Fluorinert prin sistem, la un sistem hibrid de răcire lichid-aer sau răcire cu aer cu temperaturi normale de climatizare . Un supercomputer tipic consumă cantități mari de energie electrică, aproape toate transformate în căldură, necesitând răcire. De exemplu, Tianhe-1A consumă 4,04 megawatti (MW) de energie electrică. Costul alimentării și răcirii sistemului poate fi semnificativ, de exemplu, 4 MW la 0,10 USD / kWh este de 400 USD pe oră sau aproximativ 3,5 milioane USD pe an.

Gestionarea căldurii este o problemă majoră în dispozitivele electronice complexe și afectează sistemele informatice puternice în diferite moduri. Problemele legate de puterea termică și de disiparea puterii procesorului în supercomputere depășesc cele ale tehnologiilor tradiționale de răcire a computerului . Premiile de supercomputere pentru calculul ecologic reflectă această problemă.

Ambalarea a mii de procesoare împreună generează în mod inevitabil cantități semnificative de densitate a căldurii care trebuie tratate. Cray-2 a fost răcit cu lichid și a folosit o Fluorinert „cascadă de răcire“ , care a fost forțat prin modulele sub presiune. Cu toate acestea, abordarea de răcire cu lichid scufundată nu a fost practică pentru sistemele cu mai multe dulapuri bazate pe procesoare de tip raft, iar în System X un sistem special de răcire care combina aerul condiționat cu răcirea cu lichid a fost dezvoltat împreună cu compania Liebert .

În sistemul Blue Gene , IBM a folosit în mod deliberat procesoare cu putere redusă pentru a face față densității de căldură. IBM Power 775 , lansat în 2011, are elemente strânse care necesită răcire cu apă. Sistemul IBM Aquasar folosește răcirea cu apă caldă pentru a obține eficiență energetică, apa fiind utilizată și pentru încălzirea clădirilor.

Eficiența energetică a sistemelor informatice este în general măsurată în termeni de " FLOPS pe watt ". In 2008, Roadrunner de IBM operat la 3,76 MFLOPS / W . În noiembrie 2010, Blue Gene / Q a ajuns la 1.684 MFLOPS / W și în iunie 2011 primele două locuri de pe lista Green 500 au fost ocupate de mașinile Blue Gene din New York (unul care a atins 2097 MFLOPS / W) cu clusterul DEGIMA din Nagasaki pe locul trei cu 1375 MFLOPS / W.

Deoarece firele de cupru pot transfera energia într-un supercomputer cu densități de putere mult mai mari decât aerul forțat sau agentii frigorifici care circulă pot elimina căldura reziduală , capacitatea sistemelor de răcire de a elimina căldura reziduală este un factor limitativ. Începând cu 2015, multe supercomputere existente au o capacitate de infrastructură mai mare decât cererea reală de vârf a mașinii - proiectanții, în general, proiectează în mod conservator infrastructura de alimentare și răcire pentru a gestiona mai mult decât puterea teoretică de vârf consumată de supercomputer. Proiectele pentru viitoarele supercalculatoare sunt limitate la putere - puterea termică de proiectare a supercomputerului în ansamblu, cantitatea pe care o poate gestiona infrastructura de alimentare și răcire este ceva mai mare decât consumul normal de energie așteptat, dar mai mic decât consumul teoretic maxim de putere al hardware-ul electronic.

Management de software și sistem

Sisteme de operare

De la sfârșitul secolului al XX-lea, sistemele de operare ale supercomputerelor au suferit transformări majore, pe baza schimbărilor din arhitectura supercomputerelor . În timp ce sistemele de operare timpurii au fost personalizate pentru fiecare supercomputer pentru a câștiga viteză, tendința a fost să ne îndepărtăm de sistemele de operare interne la adaptarea software-ului generic, cum ar fi Linux .

Deoarece supercomputerele moderne paralele masive separă de obicei calculele de alte servicii prin utilizarea mai multor tipuri de noduri , acestea rulează de obicei diferite sisteme de operare pe diferite noduri, de exemplu folosind un nucleu ușor mic și eficient, cum ar fi CNK sau CNL pe nodurile de calcul, dar un sistem mai mare, cum ar fi ca derivat Linux pe server și noduri I / O.

În timp ce într-un sistem tradițional multi-utilizator programarea lucrărilor este, de fapt, o problemă de sarcini pentru procesarea și resursele periferice, într-un sistem masiv paralel, sistemul de gestionare a jobului trebuie să gestioneze alocarea atât a resurselor de calcul, cât și a celor de comunicație, precum și rezolvați cu grație erorile hardware inevitabile atunci când sunt prezente zeci de mii de procesoare.

Deși majoritatea supercomputerelor moderne folosesc sisteme de operare bazate pe Linux , fiecare producător are propriul derivat Linux specific și nu există niciun standard industrial, parțial datorită faptului că diferențele în arhitecturile hardware necesită modificări pentru a optimiza sistemul de operare la fiecare proiectare hardware.

Instrumente software și transmiterea mesajelor

Arhitecturile paralele ale supercomputerelor dictează adesea utilizarea unor tehnici speciale de programare pentru a exploata viteza acestora. Instrumentele software pentru procesarea distribuită includ API-uri standard precum MPI și PVM , VTL și software open source precum Beowulf .

În cel mai obișnuit scenariu, sunt utilizate medii precum PVM și MPI pentru clustere conectate slab și OpenMP pentru mașini de memorie partajată bine coordonate. Este necesar un efort semnificativ pentru a optimiza un algoritm pentru caracteristicile de interconectare ale mașinii pe care va fi rulat; scopul este de a preveni ca oricare dintre procesoare să piardă timpul așteptând date de la alte noduri. GPGPU - urile au sute de nuclee de procesor și sunt programate folosind modele de programare precum CUDA sau OpenCL .

Mai mult, este destul de dificil să depanați și să testați programe paralele. Trebuie utilizate tehnici speciale pentru testarea și depanarea unor astfel de aplicații.

Supercomputere distribuită

Abordări oportuniste

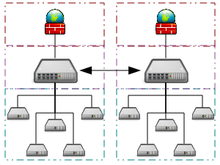

Supercomputerea oportunistă este o formă de calcul de rețea în rețea, prin care un „computer super virtual” al multor mașini de calcul voluntar slab cuplate îndeplinește sarcini de calcul foarte mari. Calculul cu rețea a fost aplicat la o serie de probleme paralele pe scară largă care necesită scale de performanță de supercomputere. Cu toate acestea, abordările de bază ale computerului în rețea și cloud care se bazează pe calculul voluntar nu pot face față sarcinilor tradiționale de supercomputere, cum ar fi simulările dinamicii fluidelor.

Cel mai rapid sistem de calcul în rețea este proiectul de calcul distribuit Folding @ home (F @ h). În aprilie 2020, F @ h a raportat 2,5 exaFLOPS de putere de procesare x86 . Dintre acestea, peste 100 de PFLOPS sunt contribuite de clienții care rulează pe diverse GPU-uri, iar restul din diferite sisteme CPU.

Platforma Berkeley Open Infrastructure for Network Computing (BOINC) găzduiește o serie de proiecte de calcul distribuite. Începând din februarie 2017, BOINC a înregistrat o putere de procesare de peste 166 petaFLOPS prin peste 762 de mii de calculatoare active (gazde) din rețea.

În octombrie 2016, Great Internet Mersenne Prime Search (GIMPS) a distribuit căutarea Mersenne Prime a realizat aproximativ 0,313 PFLOPS prin intermediul a 1,3 milioane de computere. Internet PrimeNet Server sprijină abordarea de calcul grila GIMPS, una dintre cele mai vechi și mai de succes proiecte grid computing, din anul 1997.

Abordări cvasi-oportuniste

Supercomputerea cvasi-oportunistă este o formă de calcul distribuit prin care „computerul super virtual” al multor computere dispersate geografic din rețea efectuează sarcini de calcul care necesită o putere de procesare imensă. Supercomputerea cvasi-oportunistă își propune să ofere o calitate a serviciilor mai înaltă decât calculația grilă oportunistă prin obținerea unui control mai mare asupra atribuirii sarcinilor către resursele distribuite și utilizarea informațiilor despre disponibilitatea și fiabilitatea sistemelor individuale din rețeaua de supercomputere. Cu toate acestea, execuția distribuită cvasi-oportunistă a software-ului de calcul paralel solicitant în rețele ar trebui realizată prin implementarea unor acorduri de alocare în funcție de rețea, subsisteme de co-alocare, mecanisme de alocare conștiente de topologie de comunicare, biblioteci de transmitere a mesajelor tolerante la erori și precondiționare a datelor.

Nori de calcul performanți

Cloud computingul, cu expansiunile și dezvoltările sale recente și rapide, a atras atenția utilizatorilor și dezvoltatorilor de calcul de înaltă performanță (HPC) în ultimii ani. Cloud computing încearcă să ofere HPC-ca-un-serviciu exact ca alte forme de servicii disponibile în cloud, cum ar fi software ca serviciu , platformă ca serviciu și infrastructură ca serviciu . Utilizatorii HPC pot beneficia de cloud în diferite unghiuri, cum ar fi scalabilitatea, resursele fiind la cerere, rapide și ieftine. Pe de altă parte, aplicațiile HPC în mișcare au și un set de provocări. Exemple bune de astfel de provocări sunt cheltuielile de virtualizare în cloud, închirierea mai multor resurse și problemele de latență a rețelei. În prezent se fac multe cercetări pentru a depăși aceste provocări și a face din HPC în cloud o posibilitate mai realistă.

În 2016, Penguin Computing , R-HPC, Amazon Web Services , Univa , Silicon Graphics International , Rescale , Sabalcore și Gomput au început să ofere cloud computing HPC . Norul Penguin On Demand (POD) este un model de calcul de bare metal pentru a executa cod, dar fiecărui utilizator i se dă un nod de autentificare virtualizat . Nodurile de calcul POD sunt conectate prin rețele Ethernet 10 Gbit / s nevirtualizate sau rețele QDR InfiniBand . Conectivitatea utilizatorului la centrul de date POD variază de la 50 Mbit / s la 1 Gbit / s. Citând Amazonul EC2 Elastic Compute Cloud, Penguin Computing susține că virtualizarea nodurilor de calcul nu este potrivită pentru HPC. Penguin Computing a criticat, de asemenea, faptul că norii HPC ar fi putut aloca noduri de calcul clienților care sunt la distanță, provocând o latență care afectează performanța pentru unele aplicații HPC.

Măsurarea performanței

Capacitate versus capacitate

Supercalculatoarele urmăresc, în general, maximul în capacitatea de calcul, mai degrabă decât capacitatea de calcul. De obicei, se consideră că capacitatea de calcul utilizează puterea de calcul maximă pentru a rezolva o singură problemă mare în cel mai scurt timp. Adesea, un sistem de capabilități este capabil să rezolve o problemă de o dimensiune sau complexitate pe care niciun alt computer nu o poate, de exemplu, o aplicație de simulare a vremii foarte complexă .

În schimb, calculul de capacitate este de obicei considerat ca folosind o putere de calcul eficientă din punct de vedere al costului pentru a rezolva câteva probleme oarecum mari sau multe probleme mici. Arhitecturile care se pretează să susțină mulți utilizatori pentru sarcinile de zi cu zi de rutină pot avea multă capacitate, dar nu sunt de obicei considerate supercalculatoare, dat fiind că nu rezolvă o singură problemă foarte complexă.

Valori de performanță

În general, viteza supercomputerelor este măsurată și comparată în FLOPS (operații în virgulă mobilă pe secundă) și nu în termeni de MIPS (milioane de instrucțiuni pe secundă), cum este cazul computerelor de uz general. Aceste măsurători sunt utilizate în mod obișnuit cu un prefix SI, cum ar fi tera- , combinate în stenograma TFLOPS (10 12 FLOPS, teraflops pronunțate ), sau peta- , combinate în stenograma PFLOPS (10 15 FLOPS, petaflops pronunțate .) Supercalculatoarele Petascale pot procesa un patrilion (10 15 ) (1000 trilioane) FLOPS. Exascale este performanța de calcul din gama exaFLOPS (EFLOPS). Un EFLOPS este un quintilion (10 18 ) FLOPS (un milion TFLOPS).

Niciun număr unic nu poate reflecta performanța generală a unui sistem computerizat, totuși obiectivul de referință Linpack este de a aproxima cât de repede computerul rezolvă problemele numerice și este utilizat pe scară largă în industrie. Măsurarea FLOPS este fie citată pe baza performanței teoretice în virgulă mobilă a unui procesor (derivată din specificațiile procesorului producătorului și prezentată ca „Rpeak” în listele TOP500), care este în general de neefectuat atunci când rulează sarcini reale de lucru, sau debitul realizabil, derivat din valorile de referință LINPACK și afișate ca „Rmax” în lista TOP500. Punctul de referință LINPACK efectuează de obicei descompunerea LU a unei matrice mari. Performanța LINPACK oferă unele indicații de performanță pentru unele probleme din lumea reală, dar nu corespunde neapărat cerințelor de procesare ale multor alte sarcini de lucru ale supercomputerelor, care, de exemplu, pot necesita mai multă lățime de bandă a memoriei sau pot necesita performanțe mai bune de calcul întregi sau pot avea nevoie de o sistem I / O de înaltă performanță pentru a atinge niveluri ridicate de performanță.

Lista TOP500

Din 1993, cele mai rapide supercalculatoare au fost clasate pe lista TOP500 în conformitate cu rezultatele lor de referință LINPACK . Lista nu se pretinde a fi imparțială sau definitivă, dar este o definiție actuală pe scară largă a supercomputerului „cel mai rapid” disponibil la un moment dat.

Aceasta este o listă recentă a computerelor care au apărut în partea de sus a listei TOP500, iar „Viteza de vârf” este dată ca „Rmax”. În 2018, Lenovo a devenit cel mai mare furnizor din lume pentru supercomputerele TOP500 cu 117 unități produse.

| An | Supercomputer | Rmax (TFlop / s) |

Locație |

|---|---|---|---|

| 2020 | Fujitsu Fugaku | 442.010,0 | Kobe , Japonia |

| 2018 | Summit-ul IBM | 148.600,0 | Oak Ridge , SUA |

| 2018 | IBM / Nvidia / Mellanox Sierra | 94.640,0 | Livermore , SUA |

| 2016 | Sunway TaihuLight | 93.014,6 | Wuxi , China |

| 2013 | NUDT Tianhe-2 | 61.444,5 | Guangzhou , China |

| 2019 | Dell Frontera | 23.516,4 | Austin , SUA |

| 2012 | Cray / HPE Piz Daint | 21,230,0 | Lugano , Elveția |

| 2015 | Cray / HPE Trinity | 20.158,7 | New Mexico , SUA |

| 2018 | Fujitsu ABCI | 19.880,0 | Tokyo , Japonia |

| 2018 | Lenovo SuperMUC-NG | 19,476,6 | Garching , Germania |

Aplicații

Etapele aplicării supercomputerelor pot fi rezumate în următorul tabel:

| Deceniu | Utilizări și computer implicat |

|---|---|

| Anii 1970 | Prognoza meteo, cercetare aerodinamică ( Cray-1 ). |

| Anii 1980 | Analiză probabilistică, modelare de protecție împotriva radiațiilor ( CDC Cyber ). |

| Anii 1990 | Ruperea codului forței brute ( crackerul EFF DES ). |

| Anii 2000 | Simulări de testare nucleară 3D ca înlocuitor al conduitei legale Tratatul de neproliferare nucleară ( ASCI Q ). |

| Anii 2010 | Simularea dinamicii moleculare ( Tianhe-1A ) |

| Anii 2020 | Cercetare științifică pentru prevenirea focarelor / Cercetarea reacțiilor electrochimice |

Calculatorul IBM Blue Gene / P a fost folosit pentru a simula un număr de neuroni artificiali echivalenți cu aproximativ 1% din cortexul cerebral uman, conținând 1,6 miliarde de neuroni cu aproximativ 9 trilioane de conexiuni. Același grup de cercetare a reușit, de asemenea, să folosească un supercomputer pentru a simula un număr de neuroni artificiali echivalenți cu întregul creier al unui șobolan.

Prognoza meteo modernă se bazează, de asemenea, pe supercalculatoare. Administrația Națională Oceanic si Atmospheric utilizeaza supercomputere pentru a rontai sute de milioane de observații pentru a ajuta la a face prognoze meteorologice mai precise.

În 2011, provocările și dificultățile în împingând plic în supercomputerelor au fost subliniat de IBM abandonarea lui Blue Waters proiectului petascale.

Programul avansat de simulare și calcul utilizează în prezent supercalculatoare pentru întreținerea și simularea stocului nuclear din Statele Unite.

La începutul anului 2020, COVID-19 era în centrul lumii. Supercomputerele au folosit diferite simulări pentru a găsi compuși care ar putea opri răspândirea. Aceste computere rulează zeci de ore folosind mai multe procesoare în paralel pentru a modela diferite procese.

Dezvoltare și tendințe

În anii 2010, China, Statele Unite, Uniunea Europeană și alții au concurat pentru a fi primii care au creat un supercomputer 1 exaFLOP (10 18 sau un quintilion de FLOPS). Erik P. DeBenedictis de la Sandia National Laboratories a teoretizat că un computer zettaFLOPS (10 21 sau un sextillion FLOPS) este necesar pentru a realiza o modelare completă a vremii , care ar putea acoperi cu exactitate un interval de timp de două săptămâni. Astfel de sisteme ar putea fi construite în jurul anului 2030.

Multe simulări Monte Carlo folosesc același algoritm pentru a procesa un set de date generat aleatoriu; în special, ecuațiile integro-diferențiale care descriu procesele de transport fizic , căile aleatorii , coliziunile și depunerile de energie și impuls ale neutronilor, fotonilor, ionilor, electronilor etc.Următorul pas pentru microprocesoare poate fi în a treia dimensiune ; și specializându-se la Monte Carlo, numeroasele straturi ar putea fi identice, simplificând procesul de proiectare și fabricație.

Costul operării supercomputerelor de înaltă performanță a crescut, în principal datorită creșterii consumului de energie. La mijlocul anilor 1990, un top 10 supercomputer necesar în gama de 100 kilowați, în 2010 primii 10 supercomputeri necesită între 1 și 2 megawați. Un studiu din 2010 comandat de DARPA a identificat consumul de energie drept cea mai răspândită provocare în realizarea calculelor Exascale . La acea vreme, un megawatt pe an în consumul de energie costa aproximativ 1 milion de dolari. Facilitățile de supercomputere au fost construite pentru a elimina în mod eficient cantitatea crescândă de căldură produsă de unitățile centrale de procesare multi-core moderne . Pe baza consumului de energie al listei Green 500 de supercalculatoare între 2007 și 2011, un supercomputer cu 1 exaFLOPS în 2011 ar fi necesitat aproape 500 de megawați. Au fost dezvoltate sisteme de operare pentru hardware existent pentru a economisi energie ori de câte ori este posibil. Miezurile CPU care nu erau utilizate în timpul executării unei aplicații paralelizate au fost puse în stări de consum redus de energie, producând economii de energie pentru unele aplicații de supercomputere.

Costul în creștere al operării supercomputerelor a fost un factor determinant într-o tendință de grupare a resurselor printr-o infrastructură distribuită de supercomputer. Centrele naționale de supercomputere au apărut pentru prima dată în SUA, urmate de Germania și Japonia. Uniunea Europeană a lansat Parteneriatul pentru computere avansate în Europa (PRACE) cu scopul de a crea o infrastructură pan-europeană persistentă de supercomputer cu servicii pentru a sprijini oamenii de știință din întreaga Uniune Europeană în portarea, scalarea și optimizarea aplicațiilor de supercomputere. Islanda a construit primul supercomputer cu emisii zero din lume. Situat la centrul de date Thor din Reykjavík , Islanda, acest supercomputer se bazează pe surse complet regenerabile pentru puterea sa, mai degrabă decât pentru combustibilii fosili. Clima mai rece reduce, de asemenea, nevoia de răcire activă, făcându-l una dintre cele mai ecologice facilități din lumea computerelor.

Finanțarea hardware-ului pentru supercomputer a devenit, de asemenea, din ce în ce mai dificilă. La mijlocul anilor 1990, un supercomputer de top 10 a costat aproximativ 10 milioane de euro, în timp ce în 2010 primele 10 supercomputere au necesitat o investiție cuprinsă între 40 și 50 de milioane de euro. În anii 2000, guvernele naționale au pus în aplicare diferite strategii pentru finanțarea supercomputerelor. În Marea Britanie, guvernul național a finanțat în întregime supercomputerele, iar calculul de înaltă performanță a fost pus sub controlul unei agenții naționale de finanțare. Germania a dezvoltat un model mixt de finanțare, reunind finanțarea de stat locală și finanțarea federală.

In fictiune

Mulți scriitori de ficțiune științifică au descris supercalculatoare în lucrările lor, atât înainte, cât și după construcția istorică a unor astfel de computere. O mare parte din astfel de ficțiuni se referă la relațiile oamenilor cu computerele pe care le construiesc și cu posibilitatea de a se dezvolta în cele din urmă conflicte între ei. Exemple de supercalculatoare în ficțiune includ HAL-9000 , Multivac , The Machine Stops , GLaDOS , Conflictul evitabil , Ciocanul lui Vulcan , Colossus , WOPR și Deep Thought .

Vezi si

- Conferința de supercomputere ACM / IEEE

- ACM SIGHPC

- Calcul tehnic performant

- Calculul junglei

- Supercomputerul personal Nvidia Tesla

- Calcul paralel

- Supercomputere în China

- Supercomputere în Europa

- Supercomputere în India

- Supercomputere în Japonia

- Testarea aplicațiilor de calcul de înaltă performanță

- Ultra Network Technologies

- Calcul cuantic

Note și referințe

linkuri externe

- McDonnell, Marshall T. (2013) Proiectarea supercomputerelor: un efort inițial de a surprinde impactul asupra mediului, economic și societal. Publicații și alte lucrări de inginerie chimică și biomoleculară.